[파이낸셜뉴스] 엔비디아는 넥사 AI와 협력해 로컬 인공지능(AI) 에이전트 하이퍼링크를 엔비디아 RTX AI PC에서 공식 지원한다고 13일 밝혔다.

대규모언어모델(LLM) 기반 AI 어시스턴트는 강력한 생산성 도구지만, 적절한 맥락과 정보가 없으면 적절하고 관련성 있는 답변을 제공하는 데 어려움을 겪을 수 있다. 대부분의 LLM 기반 채팅 애플리케이션은 사용자가 일부 파일을 제공해 맥락을 보충할 수 있도록 하는데, 사용자 PC에 저장된 슬라이드, 노트, PDF, 사진 등 다양한 정보에는 접근하지 못한다.

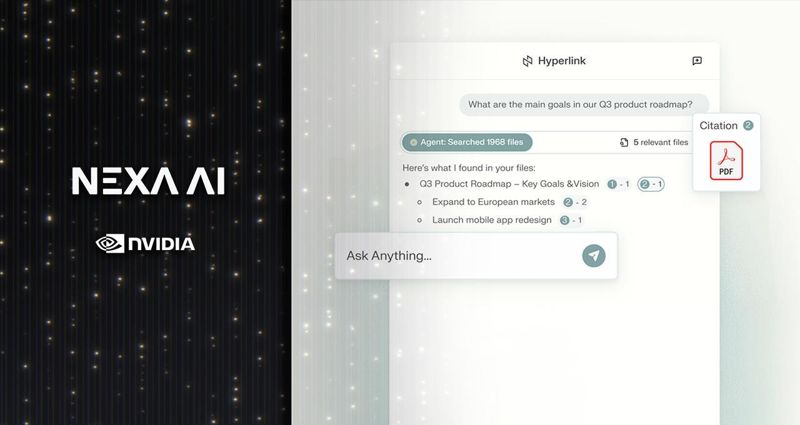

넥사 AI의 하이퍼링크는 이러한 문제를 해결하는 로컬 AI 에이전트다. 하이퍼링크는 수천 개의 파일을 빠르게 인덱싱하고, 사용자의 질문 의도를 이해하며, 맥락에 맞는 맞춤형 인사이트를 제공한다.

새롭게 공개된 버전에는 엔비디아 RTX AI PC를 위한 가속 기능을 포함하며, 검색 증강 생성(RAG) 인덱싱 속도가 3배 향상됐다. 가령 이전에 인덱싱에만 약 15분이 걸리던 1GB 용량의 폴더를 이제는 불과 4~5분 만에 검색 준비를 마칠 수 있다. 또 LLM 추론 속도도 2배 빨라져 사용자 쿼리에 대한 응답 시간이 더 단축됐다.

하이퍼링크는 생성형 AI를 활용해 수천 개의 파일 속에서 정확한 정보를 검색하며, 단순한 키워드 매칭이 아닌 사용자 쿼리의 의도와 맥락을 이해한다.

이를 위해 작은 폴더부터 컴퓨터 내 모든 파일까지 사용자가 지정한 모든 로컬 파일에 검색 가능한 인덱스로 변환한다. 사용자는 자연어로 원하는 내용을 설명하기만 하면 문서, 슬라이드, PDF, 이미지 등 다양한 파일에서 관련 정보를 찾을 수 있다.

예를 들어 사용자가 ‘두 공상과학 소설의 주제를 비교하는 독후감 작성’에 필요한 정보를 요청하면 하이퍼링크는 파일명이 단순히 ‘문학_과제_최종본.docx’으로 돼 있어도 해당 주제와 관련된 정보를 찾아낼 수 있다.

검색 기능과 RTX 가속 LLM의 추론 능력을 결합한 하이퍼링크는 사용자의 파일에서 얻은 인사이트를 바탕으로 질문에 답변한다. 다양한 출처의 아이디어를 연결하고 문서 간 관계를 식별해 명확한 출처 표기와 함께 논리적인 답변을 생성한다.

모든 사용자 데이터는 기기 내에만 저장되며 비공개로 유지된다. 즉, 개인 파일이 컴퓨터 외부로 전송되지 않아 민감한 정보가 클라우드로 유출될 걱정을 하지 않아도 된다고 엔비디아는 설명했다.

mkchang@fnnews.com 장민권 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지