KAIST 윤회준 교수팀, AI 반도체 '상보형-트랜스포머' 개발

A100보다 소모전력 625배 적어 스마트폰·노트북에서도 작동

A100보다 소모전력 625배 적어 스마트폰·노트북에서도 작동

AI 반도체 '상보형-트랜스포머'를 개발한 한국과학기술원(KAIST) AI반도체 대학원 유회준 교수는 6일 과학기술정보통신부 브리핑실에서 "초저전력의 뉴로모픽 액셀러레이터를 가지고 거대 모델인 'GPT-2'를 돌린 것은 세계 최초"라고 말했다.

■AI 반도체의 끝판왕

AI 반도체는 현재 엔비디아가 장악하고 있는 그래픽 처리장치(GPU), 다음 단계로 신경망 처리장치(NPU), 지능형 반도체(PIM) 순이며, 최종 종착지가 바로 인간의 뇌를 모사하는 뉴로모픽 컴퓨팅이다.

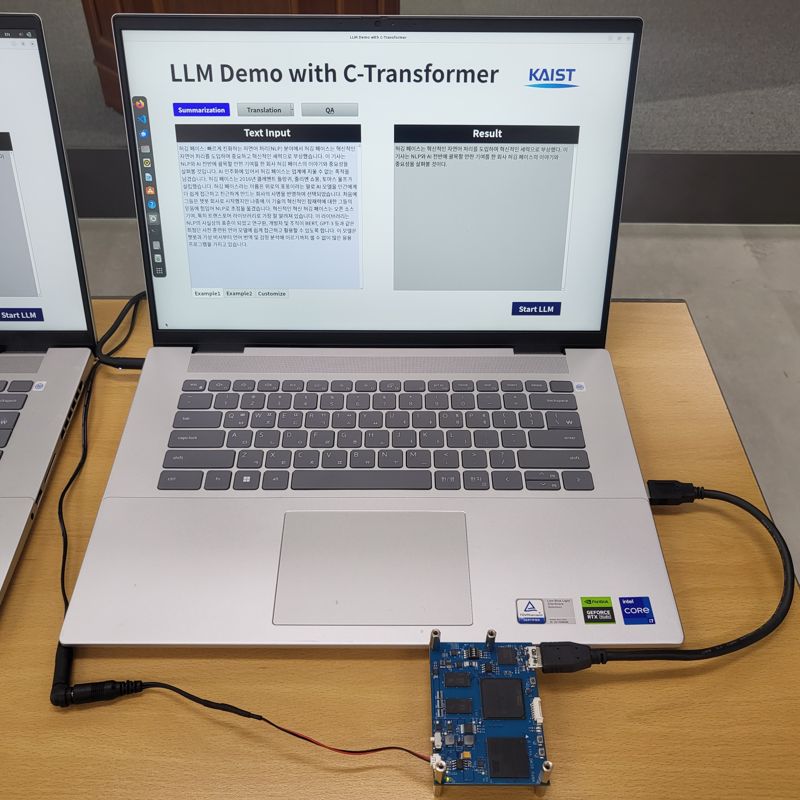

이번 반도체 개발에 참여한 KAIST 김상엽 박사가 이날 직접 시연을 해 보였다. 인터넷 연결이 안된 노트북에 '상보형-트랜스포머' 칩이 내장된 보드를 연결해 GPT-2로 문장 요약과 번역, 질의응답을 실행했다. 그결과, 일반 노트북으로 GPT-2를 실행한 것보다 최소 3배에서 최대 9배 빨랐다. 또한 갤럭시S24에 연결해도 GPT-2를 쉽고 빠르게 실행시켰다.

윤두희 과기정통부 정보통신산업정책과장은 "그동안 AI 서비스들은 LLM을 실행시키기위해 엔비디아의 A100 같은 칩으로 처리해 휴대폰으로는 도저히 불가능했다"며,

"이 뉴로모픽 액셀러레이터를 사용하게 되면 현재 아마존의 알랙사, KT의 지니 등 시중에 나와있는 AI 서비스를 클라우드와 연결하지 않고 기계 자체에서 다 처리할 수 있게 될 것"이라고 설명했다.

또한 윤 과장은 "반도체 기업과 학교 간의 협력 강화를 위해서 지난 2022년 6월에 과기정통부 PIM 예타 사업 지원을 통한 결과물"이라며 "이 사업으로 향후 추가적인 성과도 기대할 수 있을 것"이라고 전망했다.

이번 연구를 통해 개발한 AI반도체용 하드웨어 유닛은 기존 LLM 반도체 및 뉴로모픽 컴퓨팅 반도체에 비해 4가지의 특징을 지닌다.

심층 인공 신경망(DNN)과 스파이킹 뉴럴 네트워크(SNN)를 상호 보완하는 방식으로 융합한 독특한 신경망 아키텍처를 사용함으로써 정확도를 유지하면서도 연산 에너지 소모량을 최적화했다.

또 DNN과 SNN 모두를 효율적으로 활용할 수 있는 AI반도체용 통합 코어 구조를 개발했다. 특히 SNN 처리에 소모되는 전력을 줄이기 위해 출력 스파이크 추측 유닛까지 개발했다.

이와함께 LLM의 파라미터를 효과적으로 압축하기 위해 빅-리틀 네트워크 구조와 암시적 가중치 생성기법, 그리고 부호압축까지 총 3가지 기법을 사용했다. 이를 통해 GPT-2 모델의 708M개에 달하는 파라미터를 191M개로 줄였으며, 번역을 위해 사용되는 T5 모델의 402M개에 달하는 파라미터 역시 동일한 방식을 통해 76M개로 줄일 수 있었다.

김상엽 박사는 "이러한 압축을 통해 연구진은 언어 모델의 파라미터를 외부 메모리로부터 불러오는 작업에 소모되는 전력을 약 70% 감소시켰다"고 설명했다. 그러면서 "상보형-트랜스포머는 전력 소모를 GPU(엔비디아 A100) 대비 625배 만큼 줄이면서도 GPT-2 모델을 활용한 언어 생성에는 0.4초의 고속 동작이 가능하며, T5 모델을 활용한 언어 번역에는 0.2초의 고속 동작이 가능하다"고 말했다.

monarch@fnnews.com 김만기 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지