[파이낸셜뉴스] 인공지능(AI) 모델·시스템을 개발하거나 제공할 때 프라이버시 리스크를 체계적으로 관리할 수 있는 정부 차원의 모델이 나왔다.

개인정보보호위원회는 '안전한 인공지능(AI)·데이터 활용을 위한 AI 프라이버시 리스크 관리 모델'을 공개했다고 19일 밝혔다. 리스크 관리 모델에는 AI 생애주기에 걸친 프라이버시 리스크 관리의 방향과 원칙, 리스크 유형, 경감방안을 체계적으로 담겼다.

AI 시대로 빠르게 접어들면서 개인정보 유·노출 등 전형적 프라이버시 리스크는 물론, 딥페이크로 인한 인격권 침해 등 다양한 위험요소가 부각되고 있다. 이러한 리스크를 적정하게 관리하는 것은 정보주체의 보호뿐만 아니라 지속 가능하고 신뢰할 수 있는 AI를 위해 필수적이고, 리스크에 대한 체계적인 이해를 바탕으로 비례적, 합리적 경감조치를 취할 필요가 있다는 것이 정부 입장이다.

이번에 공개된 리스크 관리 모델은 AI 데이터 처리 특성, 프라이버시 리스크 유형, 리스크 경감방안 및 관리체계, 기업 사례 등을 담은 안내서로, 조치 이행에 강제성은 부여되지 않는다.

AI프라이버시 리스크 관리의 절차의 경우, AI의 유형·용례에 따른 구체적 리스크 파악해 정성적·정량적 리스크 측정을 하고, 이후 리스크에 비례하는 안전조치를 마련하도록 했다.

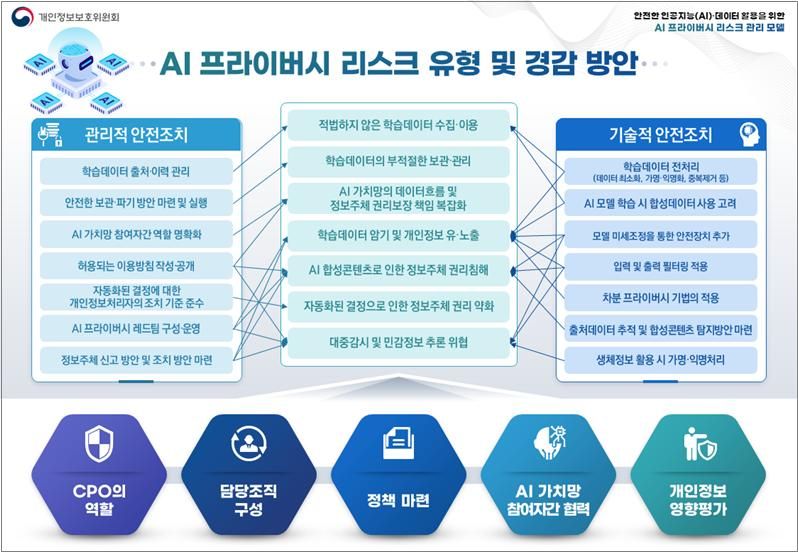

AI 프라이버시 리스크의 유형으로는 적법하지 않은 학습데이터 수집, AI학습데이터의 부적절한 보관 및 관리 등 새롭게 부각된 정보주체 권리침해, 개인정보보호법 위반 리스크 등을 중점적으로 다뤘다.

리스크 경감하기 위한 관리적, 기술적 안내조치도 담았다.. 다만 모든 조치들을 필수적으로 취해야 하는 것은 아니며, 구체적으로 리스크를 식별하고 측정한 결과 등 개별 맥락에 따라 최적의 안전조치 조합을 마련해야 한다고 조언했다.

관리적 안전 조치에는 △학습데이터 출처·이력 관리 △허용되는 이용방침 마련 △AI 프라이버시 레드팀을 통한 개인정보 침해유형 테스트 및 조치 △부적절한 답변 등에 대한 정보주체 신고방안 마련 등이 포함된다. 또 학습데이터에 민감한 정보가 포함될 개연성이 높거나 대규모 개인정보가 포함되는 경우 △개인정보 영향평가 수행도 권장된다.

기술적 안전 조치에는 △AI 학습데이터 전처리(불필요한 데이터 삭제, 가명·익명화, 중복제거 등) △AI 모델 미세조정을 통한 안전장치 추가 △입력·출력 필터링 적용 △차분 프라이버시 기법의 적용 등이 포함된다.

리스크 관리체계 관련, 개인정보보호, AI 거버넌스, 사이버보안, 안전·신뢰 등 다양한 디지털 거버넌스 요소가 상호연관되는 AI 관리체계에 따라 전통적 프라이버시 거버넌스의 재편이 필요하다고 지적했다.

개인정보위는 추후 AI 기술 발전, 개인정보 관련 법령 제·개정, 글로벌 동향 등을 고려해 리스크 관리 모델을 지속적으로 업데이트할 계획이다. 또 소규모 조직, 스타트업 및 AI 개발 유형(미세조정, 검색증강(RAG) 등) 등 세부대상, 영역 등에 특화된 안내자료도 조만간 구체화될 예정이다.

고학수 개인정보위 위원장은 "개인정보, 비개인정보가 총체적으로 활용되고 기술 발전이 지속되는 AI 영역은 불확실성이 높기 때문에 일률적 규제보다는 합리적·비례적 관리를 통해 리스크를 총체적으로 최소화하는 것이 필요하다"며 "리스크 관리 모델이 AI 기업 등이 프라이버시 리스크를 이해하고 체계적으로 관리하는 데 도움이 되길 바란다"고 말했다.

yjjoe@fnnews.com 조윤주 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지